TOP

姓名

邮件

手机号码

公司名

联系留言

广州市黄埔区瑞吉二街京广协同创新中心45号楼6-9层

trusme@trusme.com.cn

400-855-2725 / 020-38638003

020-38637770

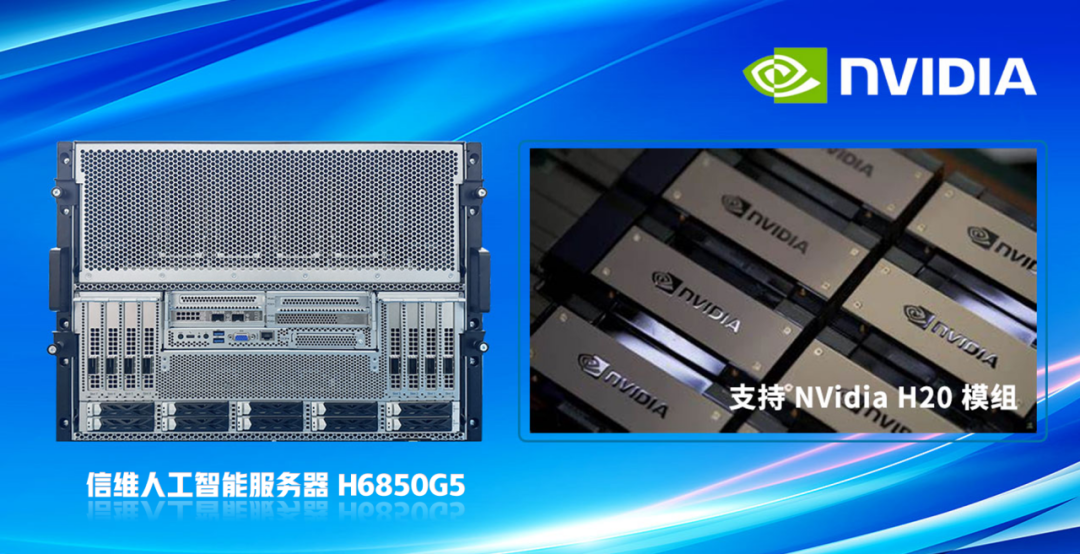

开年上新 | 信维率先发布Nvidia H20 AI算力服务器

AI 行业蓬勃发展,对计算资源的需求日益增长,技术不断进步,应用覆盖面拓展,AI将在未来扮演更加核心的角色,为企业带来更多机遇和挑战。GPU 服务器成为推动创新和解决复杂问题的关键工具之一。伴随AI需求激增,对智能算力提出更高要求。信维AI服务器全力驱动AI市场繁荣,推出面向AI大模型训练和推理场景的Nvidia H20 GPU算力服务器H6850G5。

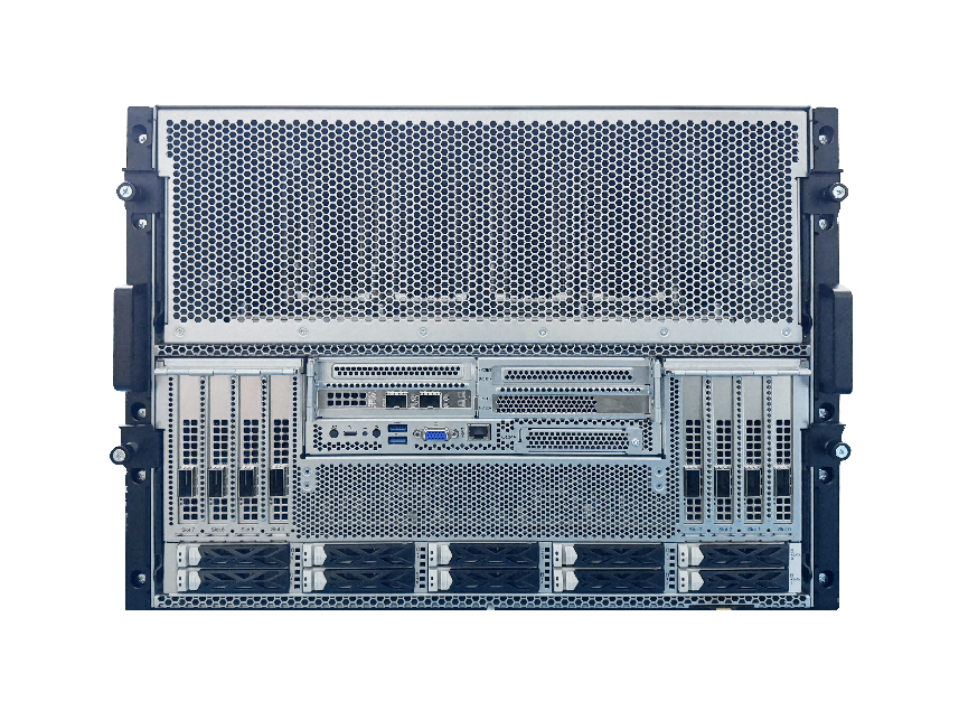

信维H6850G5 8U8卡AI算力服务器已完成与Nvidia H20 GPU的方案适配,具备大批量稳定交付能力。作为搭载第五代英特尔®至强®可扩展处理器的高性能模组型GPU服务器产品,H6850G5具备高性能、高可靠、高扩展、模块化设计等特点,能够全面满足各行业客户对算力性能提升和工作负载的需求。H6850G5系专为AI大模型训练和推理场景量身打造,拥有强大的算力和高效的数据处理能力。整机采用先进的模块化设计,8U架构使得H6850G5在散热、供电、I/O扩展性上完美适配GPU发挥出强劲性能,可应用于大规模训练、语音识别、图像分类、机器翻译等多种人工智能业务场景。

01

领先架构设计

○ 搭载2颗第五代/第四代英特尔®至强®可扩展处理器,最大可达64核心,TDP 350W;

○ 支持业界最新AI训练模组;

○ 支持多种拓扑方案:CPU-Switch 双互联模式,CPU-Switch可选X16 或X32 lane 互联,实现高带宽通信;

○ 8个PCIe 5.0 x16插槽,支持32个 DIMM DDR5内存插槽,每颗 CPU 支持 8 个内存通道,频率最高可达5600MT/s;

02

强劲AI算力

○ 支持NVidia H20模组、Intel模组及其他OAM 模组,为AI集群和大规模应用提供强大算力支撑;

○ NVidia H20模组方案,可提供 1184 TFLOPS 混合算力;

○ 最大支持10块 2.5” NVMe 硬盘;

03

高速传递

○ 支持DDR5 技术和PCIe Gen5 协议,传输速率达32GT/s;

○ 支持NVLink 900GB/s高速互联功能,实现低延时应用体验;

○ CPU-Switch可选X16 或X32 lane 互联,实现高带宽通信;

04

品质保证

○ BMC管理模块持续监控系统参数、触发告警;

○ 智能风道,高效散热设计;

○ 15个高性能热插拔风扇,N+N 冗余电源设计;

○ 冷板散热(可选)

○ 专业团队全面支撑用户定制化开发需求;

总体来说,信维H6850G5是一款优秀的GPU服务器,它具有卓越的计算性能、高速网络通信能力以及创新的能效表现。它适用于各种人工智能和深度学习等领域的高性能计算需求,同时也具有广泛的应用前景和市场前景。