TOP

姓名

邮件

手机号码

公司名

联系留言

广州市黄埔区瑞吉二街京广协同创新中心45号楼6-9层

trusme@trusme.com.cn

400-855-2725 / 020-38638003

020-38637770

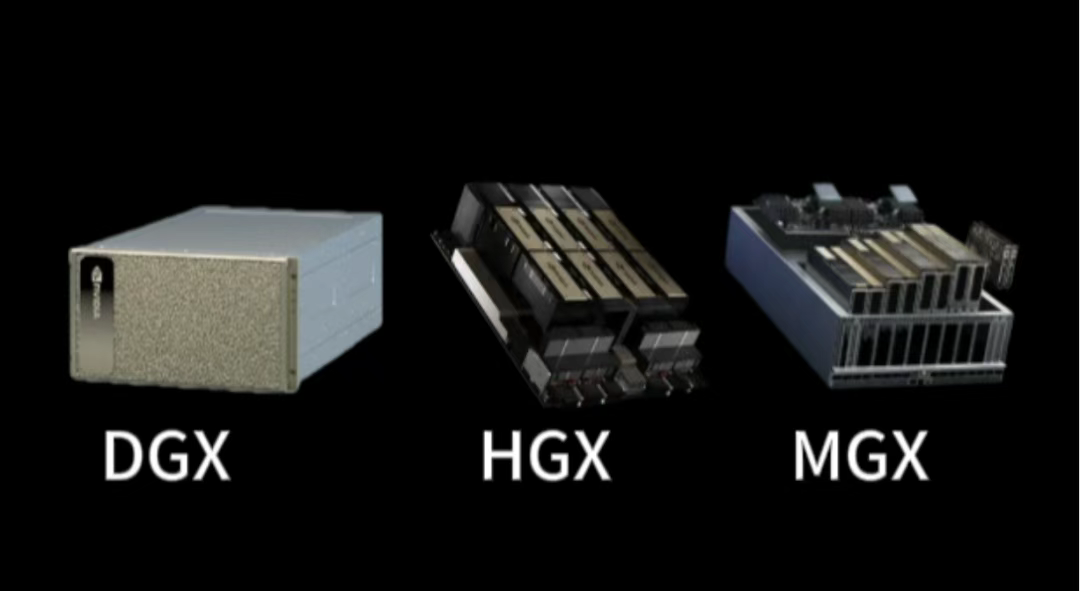

AI服务器如何选?一文读懂英伟达DGX、HGX与MGX的核心区别

在AI算力需求爆发的当下,英伟达的DGX、HGX和MGX的三大平台成为企业级AI服务器的主流选择。三者虽同属英伟达生态,却针对不同场景设计了差异化方案。本文将从技术特性、适用场景和核心优势三个维度,帮你快速理清三者的区别,找到最适合的AI算力解决方案。

DGX 是英伟达推出的全栈式高性能AI一体机,定位“即插即用的AI训练中心”。其核心特点是将硬件、软件与优化方案深度整合,为大规模AI模型训练提供 “零配置”体验。

硬件配置:采用英伟达最新架构GPU(如基于 Blackwell 架构的 DGX B200 含8颗B200 GPU,前代Hopper架构的DGX H100含8颗H100 GPU),通过 NVLink 4.0 实现GPU间超高带宽互联(单系统GPU间通信带宽达900GB/s)。

软件生态:预装完整AI软件栈,包括库达工具包、TensorFlow/PyTorch 框架优化版、NGC容器库(含100+预训练模型),并集成英伟达AI Enterprise Suite企业级支持服务。

部署效率:出厂前已完成硬件兼容性测试和软件栈优化,开机即可启动训练任务,避免企业在硬件调试、驱动适配等环节浪费时间。

适用场景:

Ø需快速启动大规模AI训练的企业(如大模型研发公司、自动驾驶算法团队);

Ø缺乏专业运维团队的科研机构、高校实验室;

Ø对算力稳定性要求极高的核心业务场景(如金融风控模型训练、医疗影像分析);

核心优势:“全栈式解决方案”带来的效率最大化——从硬件到软件的深度协同,能让GPU性能发挥至理论上限。

HGX 是英伟达推出的标准化GPU主板方案,定位“灵活扩展的 AI 服务器核心模块”。它不提供完整服务器,而是通过开放接口让合作伙伴(如DELL、浪潮、AWS)自由搭配CPU、内存、存储等组件,打造定制化AI服务器。

模块化架构:核心是一块集成多颗GPU的标准主板(如HGX H100 支持8颗 H100 GPU),支持 PCIe 5.0和 NVLink互联,兼容 x86/Arm架构CPU;

扩展能力:通过NVSwitch和 InfiniBand网络,单集群可扩展至千卡级 GPU(如 Meta 的AI集群基于HGX构建,规模达10万 + GPU);

生态开放:提供完整的硬件设计规范和驱动支持,OEM 厂商可根据需求调整散热方案、电源配置甚至外观形态;

适用场景:

Ø需定制化服务器配置的云服务商;

Ø构建大规模AI训练集群的数据中心(如互联网大厂私有AI算力集群);

Ø对硬件成本敏感,希望通过自主选型控制预算的企业;

核心优势:灵活性与扩展性的平衡--既保留了英伟达GPU的算力优势,又允许企业根据业务需求调整硬件配置,兼顾性能与成本。

MGX 是英伟达针对超大规模数据中心推出的新型模块化服务器架构,定位“高密度、高能效的AI算力集群基石”。其设计理念是通过标准化模块实现“像搭积木一样部署AI服务器”,大幅提升数据中心的算力密度与运维效率。

超高密度部署:采用共享电源、散热和网络背板的模块化设计,单个标准机箱可容纳72颗GPU(是传统服务器密度的3-5倍);

跨架构兼容:同时支持x86和Arm处理器,适配不同生态的AI应用(如边缘端 Arm 架构设备与云端x86服务器的协同);

能效优化:通过集中式电源管理和液冷散热方案,功耗比传统服务器降低30% 以上,适合超大规模集群的长期运行。

适用场景:

Ø超大规模数据中心(如英伟达“DGX SuperPOD”);

Ø边缘计算与云端协同的混合架构(如智慧城市边缘节点与中心算力集群);

Ø追求极致能效比的绿色数据中心(如碳中和要求下的算力部署);

核心优势:规模化部署的成本与效率革命——通过标准化模块设计,将数据中心的部署周期缩短50%,同时降低长期运维成本,特别适合需要百万级 GPU 算力的超大规模场景。