AIGC(AI-Generated Content),指基于生成对抗网络GAN、大型预训练模型等AI技术,自主生成创造新的文本,图像、音乐、视频、3D交互内容(如虚拟化身、虚拟物品、虚拟环境)等各种形式的内容和数据。目前,AIGC主要应用于 文字生成 音频生成 图像生成 视频生成 跨模态生成(文生图) 虚拟人生成等技术场景,赋能社交媒休、游戏、广告、建筑、编码、平面设计、产品设计、营销销售等各个需要人类知识创造的行业。

2022年11月30日,OpenAI公司发布集代码创作、文本撰写、翻译等功能于一体的聊天机器人模型ChatGPT,发布一周内用户量超过百万,两个月用户数突破一亿,创历史记录。微软、谷歌、百度、字节、阿里、腾讯等国内外主流厂家迅速布局,不断夯实通用大模型,打造产业模型,助力AI大模型产业化。生成式AI将是未来几年最重要的生产力工具,并深刻改变各个产业环节,围绕生成式AI,无论是训练还是推理端,算力需求都将有望爆发式增长。

大模型算力需求评估

基础模型(基于大规模数据集和大规模算力训练的大型预训练模型)是AIGC产业生态体系的关键AI算力底座。以ChatGPT为例,其根基还是在通用基础大模型底座GPT-3上,训练超大基础模型需要强大的GPU算力作为支撑,ChatGPT三大算力需求场景包括预训练、Finetune及日常运营。

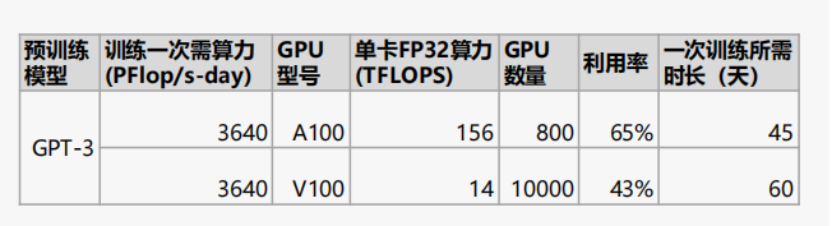

ChatGPT基于Transformer架构,进行语言模型预训练,预训练阶段单次算力需求取决于模型参数量,以GPT-3为例,以GPT-3模型为例,随着模型朝更大体量的方向演进,参数量从GPT-3 Small的1.25亿个增长到GPT-3 175B的1746亿个,一次训练所需的计算量从2.6PFlop/s-day增至3640PFlop/s-day,换算成GPU,则是需要800张A100的计算卡;报告推算,2023年-2027年,全球大模型训练端峰值算力需求量的年复合增长率有望达到78.0%,2023年全球大模型训练端所需全部算力换算成的A100芯片总量可能超过200万张。