TOP

姓名

邮件

手机号码

公司名

联系留言

广州市黄埔区瑞吉二街京广协同创新中心45号楼6-9层

trusme@trusme.com.cn

400-855-2725 / 020-38638003

020-38637770

AI推理服务器的配置选型,终于有了标准答案

在人工智能大模型(LLM)时代,性能竞争早已从训练场转移至推理服务。

与之相关的衡量指标,是服务器能够以多快的速度持续产出Token。

对于追求高吞吐量且对预算较为敏感的企业或研究团队而言,怎样的服务器配置组合会成为下一代AI推理服务器的首选呢?

8x RTX5090就是标准答案。

RTX 5090的关键优势在于单卡具备32GB的VRAM容量。

当8张卡协同运作时,会形成一个拥有256GB聚合显存的庞大内存池。

像Llama 70B这类模型,若以16位浮点数(FP16/BF16)全精度运行,其权重所需的显存大约在140GB至160GB之间。

此外,其搭载的GDDR7显存带宽高达1.79 TB/s。

由于LLM推理性能通常受限于内存带宽,GDDR7带宽的显著提升使得性能瓶颈从内存转移到了计算单元(Tensor Core)的利用率上,从而让RTX 5090能够发挥更高的理论计算能力。

而要将八卡RTX 5090的性能充分发挥,一个稳定、高效且具备出色扩展性的服务器平台至关重要。

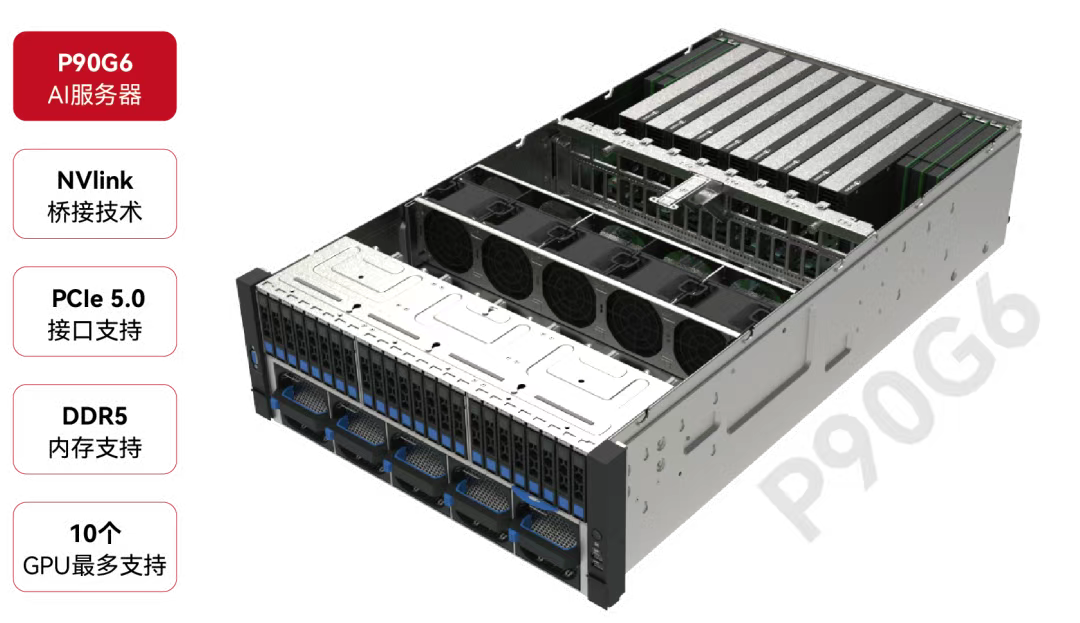

信维H4850G5I 4U GPU服务器,不仅支持多达10个GPU,还采用NVIDIA NVLink桥接技术,实现GPU间最优通信,极大提升了多卡协同推理的效率。

其模块化架构与灵活的散热方案,也为高密度GPU部署提供了可靠保障。

韩国NAVER Cloud在《An Inquiry into Data Center TCO for LLM Inference with FP8》中指出,在LLM推理过程中,降低数值精度是提升计算效率和内存带宽的有效手段之一1。

对于下一代大语言模型而言,8位浮点数(FP8)正逐步成为事实上的基线数据精度。

NVIDIA的测试数据表明,相较于传统的FP16或BF16精度,在某些场景下,FP8可实现1.3倍至1.5倍以上的加速。

近期发布的人工智能(AI)芯片已针对FP8进行了优化,使得主流常见的模型Deepseek - V3和Qwen3等均开始采用FP8向量。

RTX 5090所采用的Blackwell架构通过第五代Tensor Cores延续了技术演进,进一步优化了FP8量化涉及的动态缩放和内存移动。

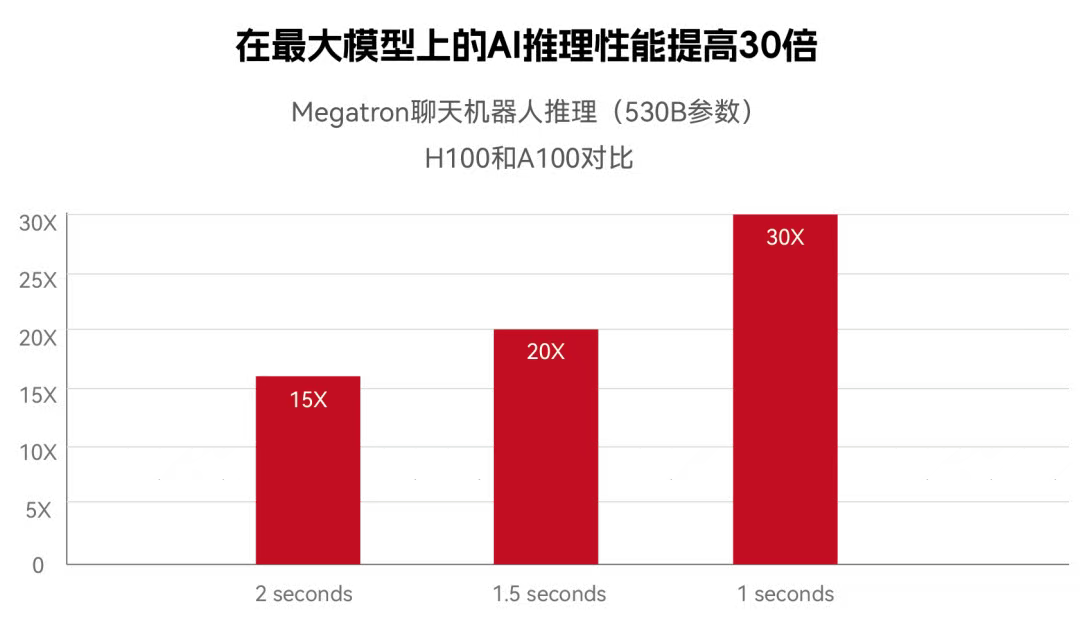

可供参考的是,H100搭配第四代Tensor Cores,使LLM推理速度相较于上一代产品(A100)提升了高达30倍2。

来自海外对Wan 14b i2v FP8模型测试3的数据显示,在显存容量不是瓶颈的情况下,单卡RTX 5090几乎与H100一样快。

在Wan 14b i2v fp8模型(480x480分辨率,81帧,100步)的推理任务中,H100耗时8分钟,而RTX 5090耗时10分钟,但我们不能忽视这两者巨大的价格差。

RTX 5090具有显著的成本优势。

据行业估算,RTX 5090所提供的VRAM每GB成本,仅为H100每GB成本的三分之一,在CapEx(资本支出)方面取得了压倒性优势。

对于更重但VRAM仍可管理的任务(例如Wan 14b i2v fp16,960x960分辨率 - 81帧,100步),RTX 5090和H100均实现了相同的1小时推理时间。

这有力地证明了RTX 5090在可管理规模的FP8工作负载中的可行性。

据技术评测网站 Cloudrift.ai 的基准测试,在使用vLLM推理引擎、并将96GB的GLM-4.5-Air-AWQ-4bit模型分片到4张卡(即管道并行P=4)的场景中,4x RTX 5090集群实现了惊人的4,622 Tokens/s吞吐量。

这个数字则比前代4x RTX 4090集群的1,731 Tokens/s高出约2.67倍。

在实际部署中,如信维H4850G5I这样支持多GPU、具备高带宽互联与模块化设计的服务器,能够充分发挥多卡5090的聚合性能。

八卡RTX 5090的出现,标志着AI推理服务正式迈入“高性价比普及”的新阶段。它不仅在硬件层面实现了容量、带宽与精度的三重突破,更以远低于专业级AI芯片的成本,让更多企业与研究团队能够轻松部署和优化大模型推理任务。

而像信维H4850G5I这样兼具灵活性、高密度与出色可维护性的服务器平台,则为这类高性价比推理配置提供了理想的承载环境。

未来,随着模型持续扩大与应用场景不断下沉,像“5090+H4850G5I”这样兼顾性能、灵活性与成本优势的配置组合,将不再只是“选项之一”,而逐渐成为AI基础设施中的“默认选择”。

综上所述,在AI推理朝着高性价比普及迈进的关键阶段,强大的GPU需要与之相匹配的卓越服务器平台作为坚实基石。

信维H4850G5I 4U GPU服务器正是顺应这一需求而诞生,其采用支持多达10个GPU的高密度设计,为八卡RTX 5090集群提供了理想的部署环境。

通过集成NVIDIA NVLink桥接技术,它确保了GPU之间拥有极高的互联带宽,能够最大程度释放多卡协同的推理性能。

同时,该服务器秉持模块化与免工具的设计理念,搭配灵活的散热方案,极大地简化了运维管理工作,保障了系统的长期稳定性与可维护性。

选择以信维H4850G5I,获得的不仅是一台服务器,更是一个集灵活性、极致性能与出色可服务性于一体的AI计算基座,助力企业在大模型应用浪潮中稳健前行。

数据引用

[1]https://arxiv.org/html/2502.01070v4 #S9

[2]https://www.nvidia.com/en-us/data-center/h100/

[3]https://www.reddit.com/r/StableDiffusion/comments/1kojahs/rtx_5090_vs_h100